ComfyUI WAN2.2: Workflows für Text- & Video-Generierung

Die KI-Videoerstellung hat sich mittlerweile weit über kurze Experimente hinaus entwickelt, und ComfyUI WAN2.2 ist ein bedeutender Fortschritt. Das ComfyUI node-basierte System basiert darauf und umfasst Text-zu-Video-, Bild-zu-Video- und hybride Arbeitsabläufe, die verwendet werden können, um qualitativ hochwertige, zeitlich kohärente Videos zu produzieren, die den Vorgaben entsprechen. Die Hauptinnovation besteht in der ausgeklügelten Mixture of Experts (MoE) Architektur, die die Arbeit bestimmten Modellen zuweist, um eine flüssigere Bewegung, filmische Bewegungseffekte und eine höhere semantische Genauigkeit zu bieten. Dies macht WAN2.2 geeignet für Geschichtenerzählen, Animation, Marketing und experimentelle Pipelines. Um komplexere Konfigurationen zu vereinfachen, verlassen sich die meisten Entwickler auf das comfyui-wanvideowrapper, und Post-Processing-Software wie HitPaw VikPea wird häufig verwendet, um Schärfe, Farbton und allgemeine visuelle Ergebnisse zu verbessern.

Teil 1: Was ist ComfyUI WAN2.2 und zentrale Fähigkeiten

Überblick über das ComfyUI WAN2.2 Modell

WAN2.2 ist ein KI-Video-Modell der nächsten Generation mit einer speziellen Anpassung an das modulare Arbeitsablaufsystem von ComfyUI. Eine Mixture of Experts (MoE) Architektur, die verschiedene Generierungsaufgaben an spezialisierte interne Komponenten delegiert, wird in WAN2.2 verwendet, im Gegensatz zu herkömmlichen Frame-by-Frame-Generatoren. Es zeichnet sich auch durch die Verwendung von dualen Rausch-Experten aus, die die Rahmenkontinuität und den Bewegungsfluss in einer Video-Sequenz erheblich verbessern.

Dieses architektonische Design ermöglicht es WAN2.2, komplexe Bewegungsmuster, Kamerabewegungen und aufwendige Szenenkompositionen zu steuern. Das Modell hat besonders Stärken in der Bewahrung semantischer Konsistenz, d. h. der Konsistenz von Charakteren, der Umgebung und Aktionen gemäß der ursprünglichen Vorgabe über die Zeit. Dadurch werden die Videos zielgerichteter und filmähnlicher, im Gegensatz zu chaotisch und lückenhaft.

WAN2.2 Versionen in ComfyUI

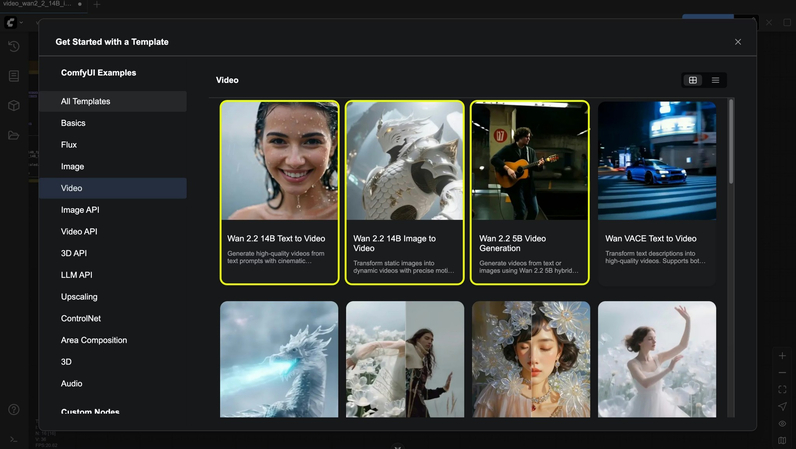

In ComfyUI bietet WAN2.2 verschiedene Arten von Arbeitsabläufen, um den unterschiedlichen kreativen Anforderungen gerecht zu werden. Am häufigsten werden Text-zu-Video-, Bild-zu-Video- und First-Last-Frame-Interpolationsarbeitsabläufe verwendet. Die Kombination von Textvorgaben mit Bildbeschränkungen sind ebenfalls mögliche hybride Designs und finden das Gleichgewicht zwischen kreativer Freiheit und visueller Kontrolle.

Diese Flexibilität gibt einem Benutzer die Möglichkeit, Arbeitsabläufe je nach Projektzielen auszuwählen, ob sie neue Inhalte erstellen oder einfach einige vorhandene Bilder animieren.

Teil 2: Installation und Einrichtung von ComfyUI WAN2.2

ComfyUI Anforderungen

Um WAN2.2 zu betreiben, wird dringend empfohlen, die neueste Version von ComfyUI zu verwenden, da ältere Versionen Kompatibilitätsprobleme verursachen oder einige Funktionen fehlen können. Hardwareseitig ist eine aktuelle GPU ein Muss. WAN2.2 kann mit GPUs betrieben werden, die etwa 12 GB VRAM haben, und 16 GB oder mehr ist stabiler und hat eine höhere Videoausgabe. Zuverlässige CUDA-Unterstützung ist eine gängige Wahl bei NVIDIA-GPUs. SSD-Speicher ist schnell und hat genügend Bandbreite des Systemspeichers, was auch dazu beiträgt, Engpässe bei der Generierung großer Bildfolgen zu reduzieren.

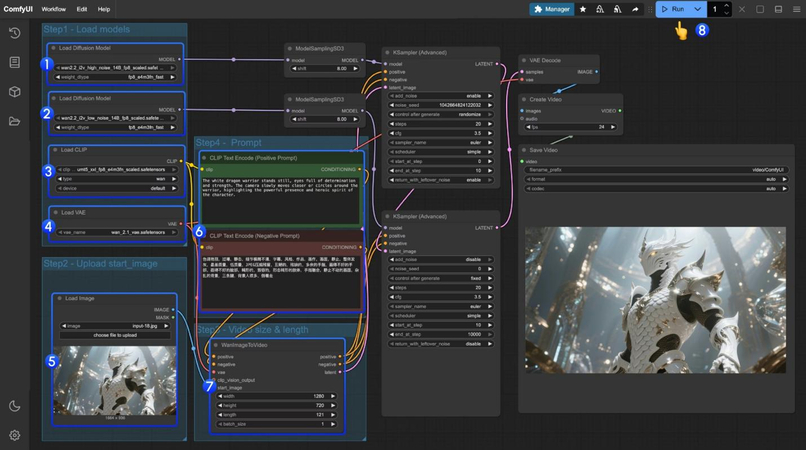

Workflow-Vorlagen und Modell-Dateien

Die meisten Benutzer beginnen mit dem Import bereits erstellter Workflow-Vorlagen von WAN2.2 in ComfyUI. Alle notwendigen Knoten für Sampling, Decodierung und Bildsequenzierung sind in diesen Vorlagen enthalten, was Setup-Fehler minimiert und Zeit spart. WAN2.2 Arbeitsabläufe basieren auf verschiedenen Modell-Dateien wie dem Hauptdiffusionsmodell, einem kompatiblen VAE und Textcodierern. Text-zu-Video- und Bild-zu-Video-Workflows sind normalerweise getrennt. Nachdem sie in die richtigen Verzeichnisse platziert wurden, laden sich die Arbeitsabläufe konsistent und sind anpassbar.

WanVideoWrapper Integration

Um die Verwaltung zu erleichtern, greifen die Ersteller auf ComfyUI WanVideoWrapper zurück, der von zahlreichen Erstellern verwendet wird. Es bündelt die Parameter, die häufig geändert werden, hält die Knotendiagramme ordentlich und standardisiert das Verhalten in WAN2.2 Arbeitsabläufen. Dies ermöglicht schnellere Iterationen, einfachere Tests und eine einfachere Nutzung durch die Community-Voreinstellungen sowohl für Anfänger als auch für fortgeschrittene Benutzer.

Teil 3: Zentrale WAN2.2 Arbeitsabläufe in ComfyUI

1. Text-zu-Video (T2V) Workflow

Basierend auf schriftlichen Anweisungen erzeugt der Text-zu-Video-Workflow komplette Video-Sequenzen. Sobald eine WAN2.2 T2V-Vorlage geladen wurde, gibt der Benutzer Parameter wie die Anzahl der Frames und die Auflösung an und zeichnet Vorgaben auf, die die Beschreibung von Szenen, Bewegung, Kamerabewegung und Stil entsprechen. WAN2.2 übersetzt diesen Code in fließende Bewegungen mit gesunder Beleuchtung und Verhalten des Subjekts und liefert oft filmische Ergebnisse. T2V eignet sich gut für konzeptionelle Visualisierungen, narrative Konzepte und kreative Experimente.

2. Bild-zu-Video (I2V) Workflow

Die Bild-zu-Video-Bildverarbeitung beginnt mit einem eingefrorenen Bild, das als visueller Anker dient. WAN2.2 zeigt die Animation des Bildes im Einklang mit einer zeitgerechten Anweisung im Gegensatz zur Rauschgenerierung. Es funktioniert am besten, wenn die Identität des Charakters, Branding oder Aspektcharakter von Bedeutung ist, und wird daher oft verwendet, um Porträts, Illustrationen und Produktvisuals zu animieren.

3. First-Last Frame (Fun InP) Workflow

Dieser Workflow arbeitet mit zwei Bildern, um den Beginn und das Ende eines Videos zu spezifizieren. Die dazwischen liegenden Frames werden durch WAN2.2 erstellt, was einen sanften Übergang ermöglicht. Es ist effektiv bei Transformationen, Vergleichen und strukturierten sowie geschichtengetriebenen Animationen.

4. Optionale erweiterte Workflows

Zusätzlich zu regulären Arbeitsabläufen kann WAN2.2 auf anspruchsvollere ComfyUI-Konfigurationen erweitert werden. Dies sind kontrollbasierte Workflows, die durch Pose- oder Tiefendaten gesteuert werden, sowie experimentelle audio-gesteuerte Pipelines, bei denen Klang verwendet werden kann, um Bewegung oder Zeitplanung zu steuern. Obwohl diese Workflows weniger benutzerfreundlich sind, verdeutlichen sie die Flexibilität von WAN2.2 im modularen System von ComfyUI.

Teil 4: Praktische Nutzungsszenarien von WAN2.2 in ComfyUI

1. Kreative Videoerstellung

WAN2.2 ist beliebter in künstlerischen und narrativen Projekten. Produzenten nutzen seine Filmfunktionen, um Kurzfilme, Cartoons und experimentelle Bilder zu erstellen, die sonst zeitaufwendig in der Realität durch Zeichnen oder Drehen erstellt werden müssten.

2. Content-Marketing und soziale Medien

WAN2.2 comfyui kann in der Vermarktung von Werbeclips, Social-Media-Bildern und Markengeschichteninhalten verwendet werden, da es eine schnellere Erstellung von Inhalten ermöglicht. Die Arbeitsabläufe können schnell iteriert werden, wobei minimale oder keine Produktionsinfrastruktur erforderlich ist, indem sie auf einer Grundlage von Vorgaben betrieben werden.

3. Animation und benutzerdefinierte Steuerung

Animatoren profitieren von den First-Last-Frame- und kontrollbasierten Workflows von WAN2.2, die eine präzise Manipulation von Bewegung und Übergängen ermöglichen. Diese Funktionen erleichtern die Integration von KI-generierten Aufnahmen in größere Animationspipelines.

4. Audio-gesteuertes Video

Audio-gesteuerte Arbeitsabläufe ermöglichen innovative kreative Möglichkeiten und erlauben visuelle Synchronität von Musik, Dialog oder leistungsbasierten Arbeiten. Dies ist besonders attraktiv für Musiker, digitale Künstler und experimentelle Medienkünstler.

Teil 5: Videos, die mit ComfyUI WAN2.2 erstellt wurden, mit VikPea verbessern

Selbst die ausgeklügeltesten Modelle, wie WAN2.2, benötigen in der Regel eine Nachbearbeitung im Falle von KI-generierten Videos. Probleme wie leichtes Flackern, mangelnde Detailgenauigkeit, ungleichmäßige Farben und wahrnehmbares Rauschen in dunklen Szenen sind typisch. Die Verbesserung dieser Ausgaben wird sie auf professionelle Standards bringen.

HitPaw VikPea löst diese Probleme, indem es auf KI-gesteuerte Verbesserungstools zurückgreift, die speziell für die Videoverbesserung entwickelt wurden. Die Funktionen ermöglichen es, das rohe KI-generierte Filmmaterial auf ein visuelles Niveau zu verfeinern, das für die Verwendung in einem professionellen Kontext geeignet ist.

Hauptmerkmale von HitPaw VikPea

- KI-Video-Generator: Erstellen Sie Videos aus Text, Bildern oder kreativen Effekten.

- KI-Video-Reparatur: Korrupted, beschädigte oder nicht abspielbare Videodateien müssen repariert werden.

- Video färben: Färben Sie verblasste oder schwarz-weiße Videos natürlich.

- Video auf 4K verbessern: Upgrade der Videoauflösung auf 4K für schärferes, klareres und professioneller aussehendes Material.

- Benutzerfreundliche Bedienung: Intuitive Schnittstelle, die minimale technische Expertise für professionelle Ergebnisse erfordert.

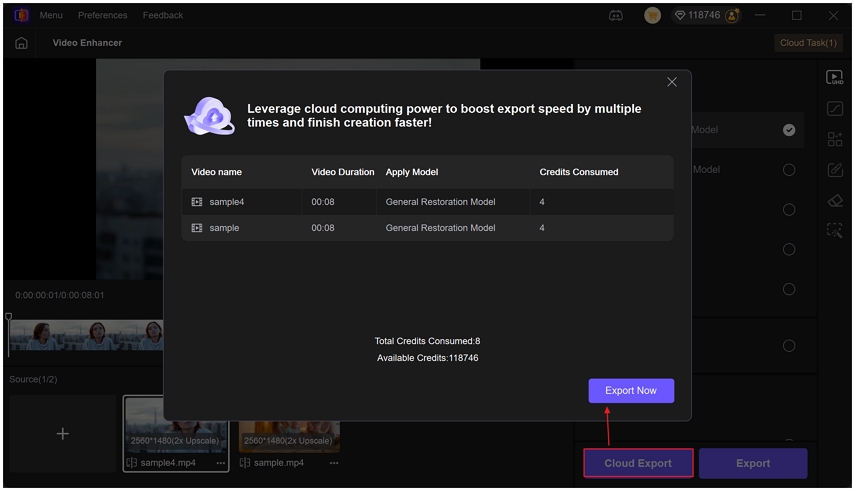

- Batch-Verarbeitung: Ermöglicht die Verbesserung mehrerer Videos gleichzeitig.

- Vorschaufunktion: Ermöglicht einen Echtzeitvergleich zwischen Original- und verbessertem Filmmaterial.

So verbessern Sie KI-generierte Videos von ComfyUI WAN2.2 mit HitPaw VikPea

Schritt 1: Installieren und Herunterladen

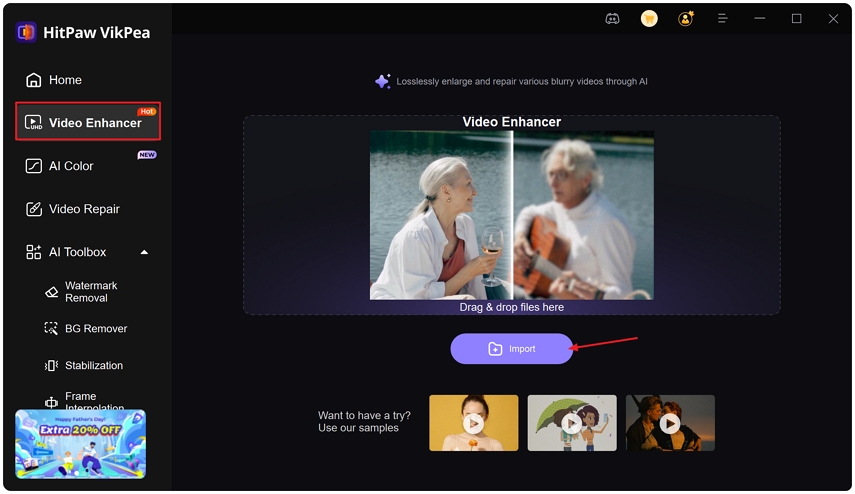

Gehen Sie zur offiziellen Website und laden Sie HitPaw VikPea herunter. Nachdem es installiert ist, starten Sie die Anwendung und melden Sie sich an, wenn es erforderlich ist.

Schritt 2: Bringen Sie Ihr Filmmaterial in den Video-Enhancer

Klicken Sie im linken Bereich, um das Video-Enhancer-Modul zu öffnen. Drücken Sie das Symbol, um Ihre Videodatei in die Schnittstelle zu importieren.

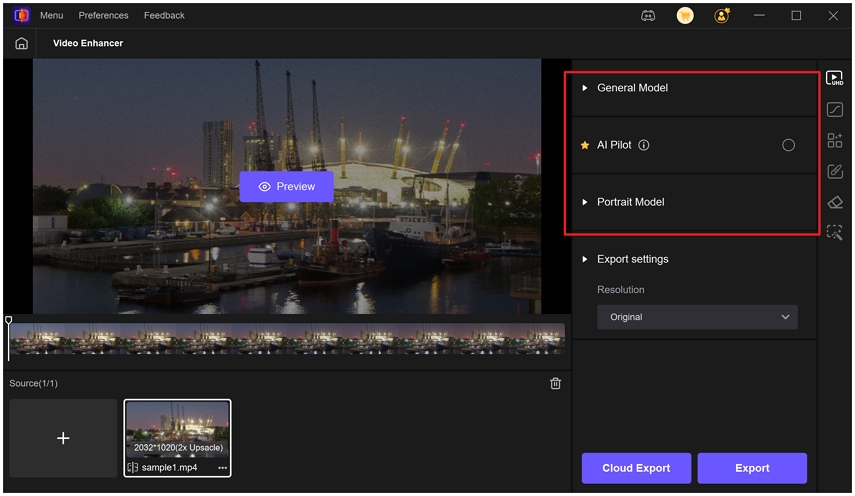

Schritt 3: Verwenden Sie das geeignete KI-Modell

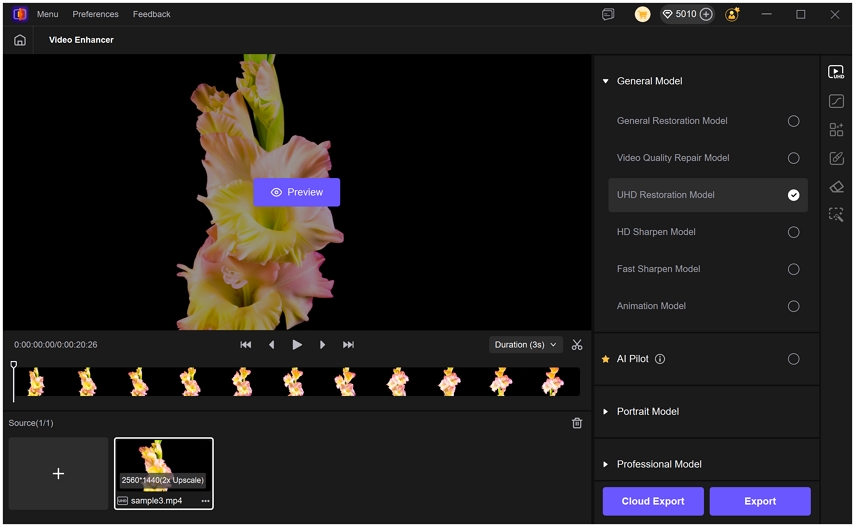

Zusätzlich zu einem allgemeinen Modell, das die Verbesserung insgesamt anwendet, gibt es mehrere spezialisierte Modelle, die je nach besonderen Verbesserungsbedürfnissen auf das Video angewendet werden können.

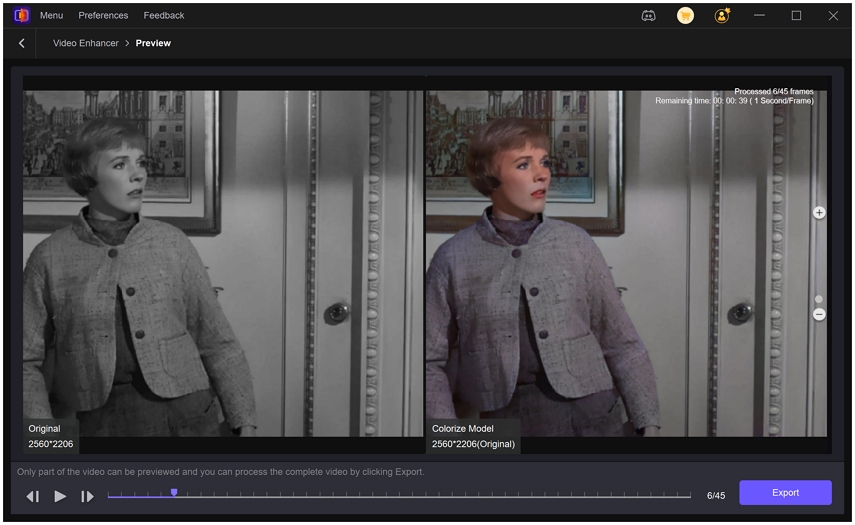

Das Colorize-Modell fügt den Videos in Schwarzweiß oder Videos, die verblasst sind, eine realistische Farbe hinzu.

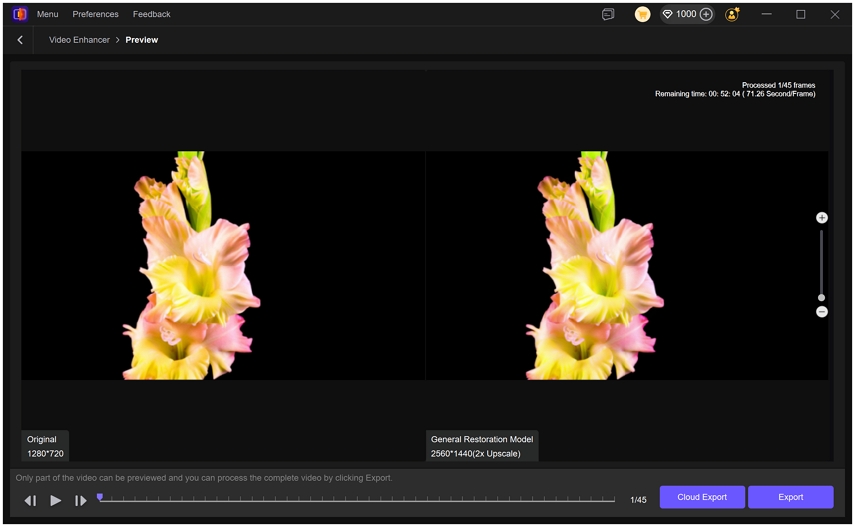

Sie können auch andere Modelle wie das UHD-Restaurierungsmodell anwenden, das die Videoqualität eines hochauflösenden 720p-Videos weiter verbessert, die Sichtbarkeit erhöht und die Schärfe wiederherstellt.

Wählen Sie Ihre Vorschau-Länge (3 oder 5 Sek.). Falls Sie nur einige Elemente des Videos verbessern müssen, verwenden Sie das Schneidwerkzeug. Stellen Sie die Ausgabeauflösung und das Format ein.

Tipps: Falls Sie sich nicht sicher sind, welches Modell zu verwenden ist, verwenden Sie AI Pilot. Dieser wird Ihr Video automatisch prüfen und die am besten geeignete Verbesserung empfehlen.

Schritt 4: Vorschau und Speichern

Nachdem Sie alle notwendigen Anpassungen vorgenommen haben, klicken Sie auf Vorschau, um die Vorher-Nachher-Ergebnisse Ihres Videos zu vergleichen. Dies lässt Sie den Unterschied zwischen der Original- und der verbesserten Version klar erkennen, bevor Sie den endgültigen Schritt ausführen.

Schritt 5: Exportieren oder Cloud-Export

Sobald Sie mit der Vorschau zufrieden sind, wählen Sie Exportieren oder Cloud-Export, um Ihr Video zu speichern. Genießen Sie verbesserte Videos mit atemberaubender Klarheit.

Workflow-Integrationszusammenfassung

Der Workflow ist einfach und besteht aus: Erstellen eines Videos in ComfyUI, Exportieren, Verbessern in VikPea und Exportieren der erstellten Version. Der Gesamteffekt des Prozesses ist eine Erhöhung der visuellen Qualität, flüssige Wiedergabe und ein professionelleres Aussehen, das zur Förderung, zum Verkauf oder zur Präsentation eines Portfolios verwendet werden kann.

FAQs zu ComfyUI WAN2.2

Es wird empfohlen, eine zeitgemäße GPU mit mindestens 12 GB VRAM und 16 GB oder mehr zu haben, um eine höhere Leistung bei langen Videos zu gewährleisten.

WAN2.2 ist normalerweise unter Apache 2.0 verfügbar, kann jedoch kommerziell genutzt werden. Bestimmte Bedingungen der Modelle sollten ebenfalls berücksichtigt werden, um die Einhaltung sicherzustellen.

Text-zu-Video wird basierend auf reinen Vorgaben erstellt, und Bild-zu-Video basiert auf der Animation eines bereits vorhandenen Bildes, was eine stärkere visuelle Konsistenz bietet.

Ja. Anfänger sollten Vorlagen, comfyui wanvideowrapper verwenden und in Community-Materialien nach Wissen suchen.

Fazit

ComfyUI WAN2.2 ist bereits zu einem leistungsstarken Werkzeug für die Erstellung hochwertiger KI-Videos geworden. Sein fortschrittliches Design, anpassbarer Workflow und hohe semantische Präzision ermöglichen es den Erstellern, die Ergebnisse des Films direkt in ComfyUI zu generieren. Die WAN2.2 comfyui Workflow-Optionen können genutzt werden, um Geschichten zu erzählen, zu vermarkten und zu animieren und bieten umfangreiche kreative Möglichkeiten.

Entwickler können KI-generierte Videos mit HitPaw VikPea verfeinern, um einen Zustand zu erreichen, in dem sie in der realen Welt als hochgradig verfeinert und professionell eingesetzt werden können.

Kommentar hinterlassen

Bewertung zu HitPaw-Artikeln erstellen