Beste GPU für KI 2026: Training, Inferenz & Creator-Workflows

Die Landschaft der Künstlichen Intelligenz hat sich schnell verändert. Egal, ob Sie große Sprachmodelle (LLMs) trainieren oder ein Ersteller sind, der 4K-Videos verbessern möchte, die Wahl der besten GPU für KI ist die wichtigste Hardware-Entscheidung, die Sie treffen werden. Im Jahr 2026 ist der Markt vielfältiger denn je, mit spezialisiertem Silizium, das für alles von massiven neuronalen Netzen bis hin zu Echtzeit-generativer Kunst entwickelt wurde.

Teil 1. Was macht eine GPU gut für KI?

Nicht alle Grafikkarten sind gleich, wenn es um maschinelles Lernen geht. Um die beste Grafikkarte für KI zu finden, müssen Sie über Gaming-Benchmarks hinausblicken und sich auf "Compute"-Metriken konzentrieren.

Wichtige Spezifikationen, die für KI relevant sind

- CUDA / ROCm Unterstützung: NVIDIAs CUDA bleibt der Branchenstandard und macht eine NVIDIA-GPU für das KI-Training zur kompatibelsten Wahl für die meisten Bibliotheken wie PyTorch und TensorFlow.

- VRAM-Größe (8GB / 12GB / 24GB+): Der Videospeicher bestimmt die Größe des Modells, das Sie laden können. Für GPUs für Deep Learning ist 24GB der "Sweet Spot" für lokale Workstations, während Unternehmensaufgaben 80GB+ erfordern.

- Tensor Cores / KI-Beschleuniger: Dies sind spezialisierte Hardwareeinheiten, die für Matrixmultiplikation - die "Mathematik" der KI - entwickelt wurden.

- Speicherbandbreite: Eine hohe Bandbreite (gemessen in GB/s) stellt sicher, dass Daten schnell zwischen dem Speicher und den Kernen fließen, um Engpässe zu vermeiden.

- Strom- und Kühlungsüberlegungen: KI-Aufgaben laufen oft stunden- oder tagelang mit 100 % Last; ein robustes thermisches Management ist unerlässlich.

Training vs. Inferenz vs. KI-Erstellung

- Training: Erfordert den höchsten VRAM und die Skalierbarkeit mit mehreren GPUs (NVLink), um Modelle von Grund auf zu erstellen.

- Inferenz: Ausführen eines vortrainierten Modells. Priorisiert Stabilität und Kosten pro Anfrage.

- KI-Ersteller: Konzentrieren sich auf die beste KI-GPU-Leistung innerhalb kreativer Software. Diese Nutzer profitieren am meisten von der GPU-Beschleunigung in benutzerfreundlichen Tools, die Video- und Bildverbesserung behandeln.

Teil 2. Beste GPUs für KI nach Anwendungsfall (2026)

Die Auswahl der besten GPU für KI erfordert es, Ihre spezifische Arbeitslast mit der richtigen Hardware-Ebene abzugleichen. Hier sind die besten Kandidaten für 2026.

1. Beste GPU für KI-Training (Professionell & Unternehmen)

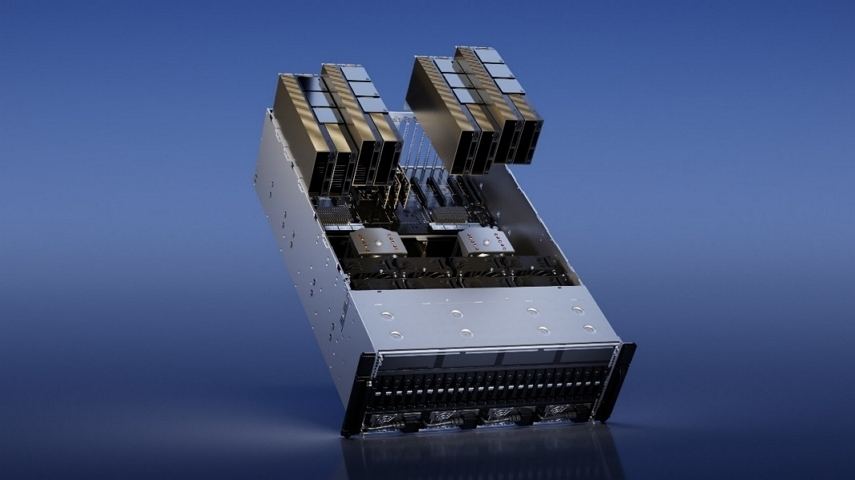

NVIDIA H100 / H200 Tensor Core

Die H-Serie repräsentiert den Höhepunkt der NVIDIA-GPU für KI-Training. Die H200 ist speziell eine Verfeinerung der H100-Architektur und bietet nahezu die doppelte Kapazität für große Sprachmodelle (LLMs).

Ideal für: Rechenzentren, Forschungsinstitute und Unternehmen, die Modelle mit Milliarden von Parametern von Grund auf trainieren.

Wichtige Spezifikationen:

- Markteinführungsdatum: H100 (Okt 2022) / H200 (Nov 2024)

- Architektur: Hopper

- Speicher: Bis zu 141GB HBM3e (H200)

- Speicherbandbreite: 8 TB/s

- Tensor Core-Leistung: ~3,958 TFLOPS (FP8 mit Sparsity)

- Strom (TDP): Bis zu 700W (SXM) / 350-600W (PCIe)

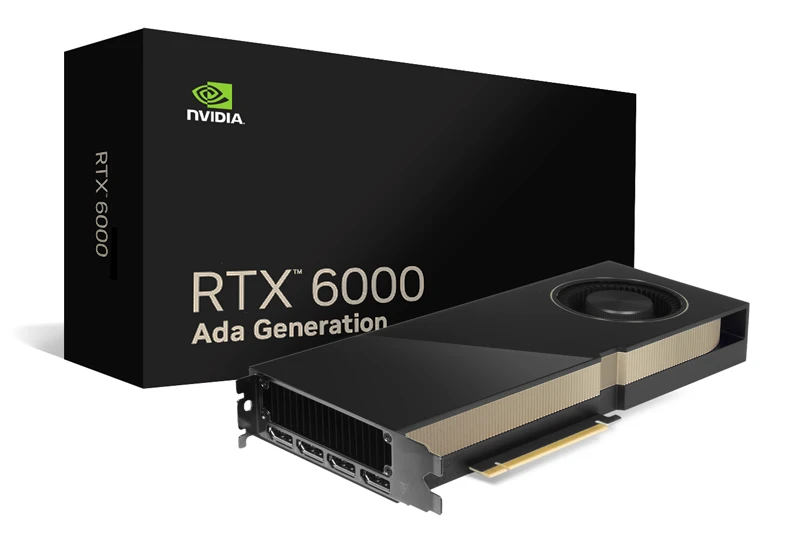

RTX 6000 Ada Generation

Dies ist die ultimative professionelle Workstation-Karte. Sie bietet nahezu dasselbe "Gehirn" wie die RTX 4090, aber mit doppelt so viel VRAM und professioneller Treiberunterstützung.

Ideal für: KI-Forscher und Ingenieure, die hohen VRAM auf einer lokalen Workstation für Feinabstimmungen benötigen.

Wichtige Spezifikationen:

- Markteinführungsdatum: Dez 2022

- Architektur: Ada Lovelace

- Speicher: 48GB GDDR6

- Speicherbandbreite: 960 GB/s

- Tensor Core-Leistung: 1,457 TFLOPS (Sparse)

- Strom (TDP): 300W

2. Beste GPU für KI-Inferenz & Bereitstellung

NVIDIA RTX 4090

Allgemein als beste Grafikkarte für KI für Verbraucher angesehen, macht der 4090 mit 24GB VRAM ihn zum Standard für lokale LLM-Inferenz.

Ideal für: Unabhängige KI-Entwickler und leistungsstarke Endbenutzer.

Wichtige Spezifikationen:

- Markteinführungsdatum: Sept 2022

- Architektur: Ada Lovelace

- Speicher: 24GB GDDR6X

- Speicherbandbreite: 1,01 TB/s

- Tensor Core-Leistung: 1,321 TFLOPS (Sparse)

- Strom (TDP): 450W

RTX 3090 (Der Wert-Arbeitstier)

Im Jahr 2026 bleibt die 3090 eine der besten Wahl für GPUs für Deep Learning, da sie 24GB VRAM zu einem Bruchteil der Kosten von 40er-Serie-Karten bietet.

Ideal für: Studierende und budgetbewusste Forscher.

Wichtige Spezifikationen:

- Markteinführungsdatum: Sept 2020

- Architektur: Ampere

- Speicher: 24GB GDDR6X

- Speicherbandbreite: 936 GB/s

- Tensor Core-Leistung: 564 TFLOPS (Sparse)

- Strom (TDP): 350W

3. Beste GPU für KI-Ersteller (Video, Bild & generative KI)

NVIDIA RTX 4070

Die RTX 4070 ist eine der ausgewogensten Wahlmöglichkeiten für KI-Ersteller. Sie bietet genug VRAM und Tensor Core-Leistung, um KI-Video-Upscaling, Bildverbesserung und generative KI-Workflows effizient zu bewältigen.

Am besten für:

- KI-Videoverbesserung

- Bild- und Animationsgenerierung

- Inhaltsersteller

Wichtige Spezifikationen:

- Markteinführungsdatum: April 2023

- Architektur: Ada Lovelace

- Speicher: 12GB GDDR6X

- Speicherbandbreite: 504 GB/s

- Tensor Core-Leistung: 466 TFLOPS (Sparse)

- Strom (TDP): 200W

RTX 4060 Ti (16GB Version)

Die RTX 4060 Ti ist eine Einstiegslösung für KI-Ersteller und Anfänger. Obwohl sie in VRAM begrenzt ist, bietet sie dennoch eine solide KI-Beschleunigung für leichtere Arbeitslasten wie KI-Bildverbesserung und kurze Videobearbeitung.

Am besten für:

- Einsteiger-KI-Ersteller

- Erlernen von KI-Workflows

Wichtige Spezifikationen:

- Markteinführungsdatum: Mai 2023

- Architektur: Ada Lovelace

- Speicher: 16GB GDDR6

- Speicherbandbreite: 288 GB/s

- Tensor Core-Leistung: 353 TFLOPS (Sparse)

- Strom (TDP): 165W

Teil 3. Profi-Tipp: Beschleunigen Sie KI-Aufgaben mit GPU-optimierter Software

Obwohl es eine großartige Grundlage ist, die beste GPU für Deep Learning zu haben, bestimmt die Software, die Sie verwenden, Ihre tatsächliche Produktivität. Für Ersteller speziell kann die Hardwareleistung oft durch schlecht optimierte Tools eingeschränkt werden.

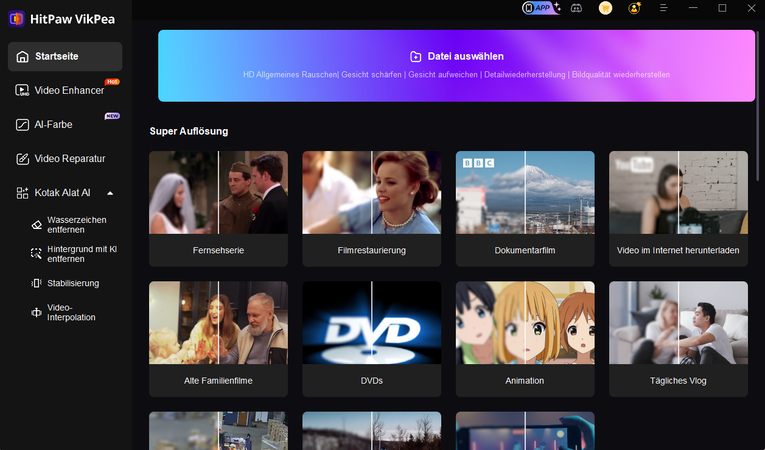

HitPaw VikPea ist eine KI-gestützte Videosuite, die vollständig für die GPU-Beschleunigung optimiert ist. Egal, ob Sie eine RTX 4090 oder eine bescheidenere 4060 Ti verwenden, VikPea nutzt die Tensor Cores Ihrer NVIDIA-Karte, um Aufgaben bis zu 30x schneller als traditionelle CPU-basierte Software zu verarbeiten.

HitPaw VikPea Hauptmerkmale:

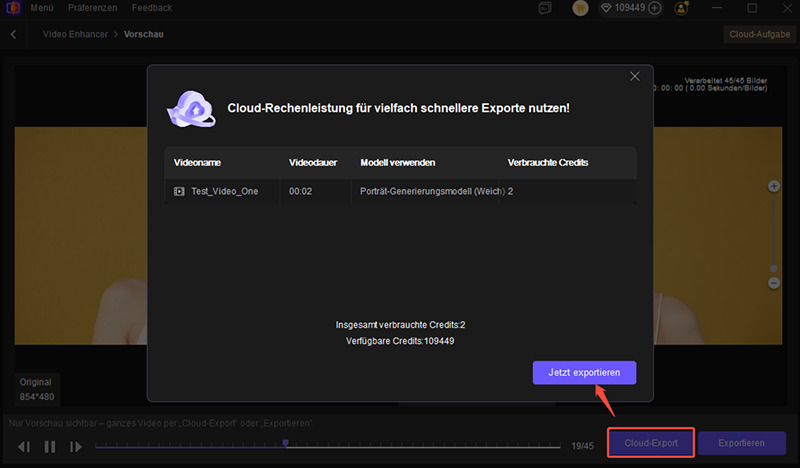

- Hybrid-Power: Es unterstützt sowohl lokale GPU-Beschleunigung als auch Cloud-Computing, sodass Sie schwere Aufgaben auslagern können, wenn Ihre lokale Hardware beschäftigt ist.

- Videos in 4k umwandeln: Die Umwandlung von körnigem 1080p-Footage in filmisches 4K war noch nie schneller.

- Zielgerichtete KI-Modelle: Vikpea verfügt über spezialisierte Modelle, wie das allgemeine Modell für Gesamtklarheit; Denoise-Modell, um visuelles Rauschen aus Aufnahmen bei schwachem Licht zu entfernen; Portrait-Modell, um Gesichtsdetails und Hauttexturen zu verbessern usw.

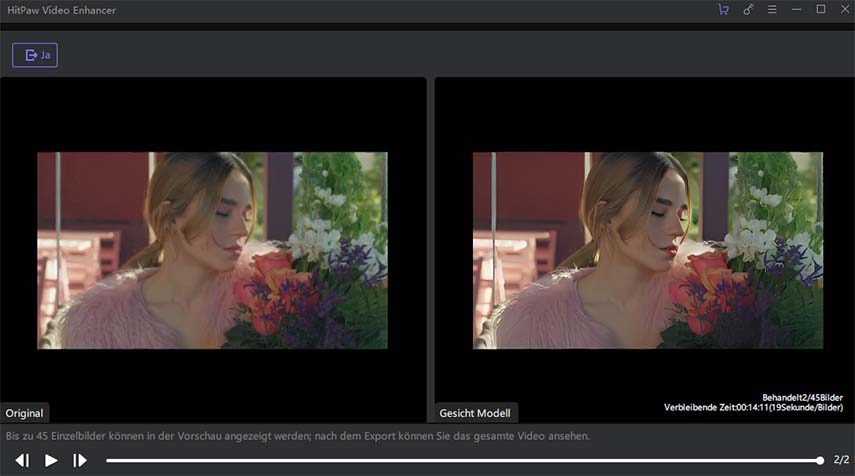

- Echtzeit-Vorschau: Sehen Sie die KI in Aktion mit einer Split-Screen-Ansicht, bevor Sie sich für den endgültigen Export entscheiden.

Schritt-für-Schritt-Anleitung zum Upscaling von Videos mit GPU

Schritt 1. Starten & Importieren:

Öffnen Sie Vikpea und ziehen Sie Ihr Video in das Modul Video Enhancer.

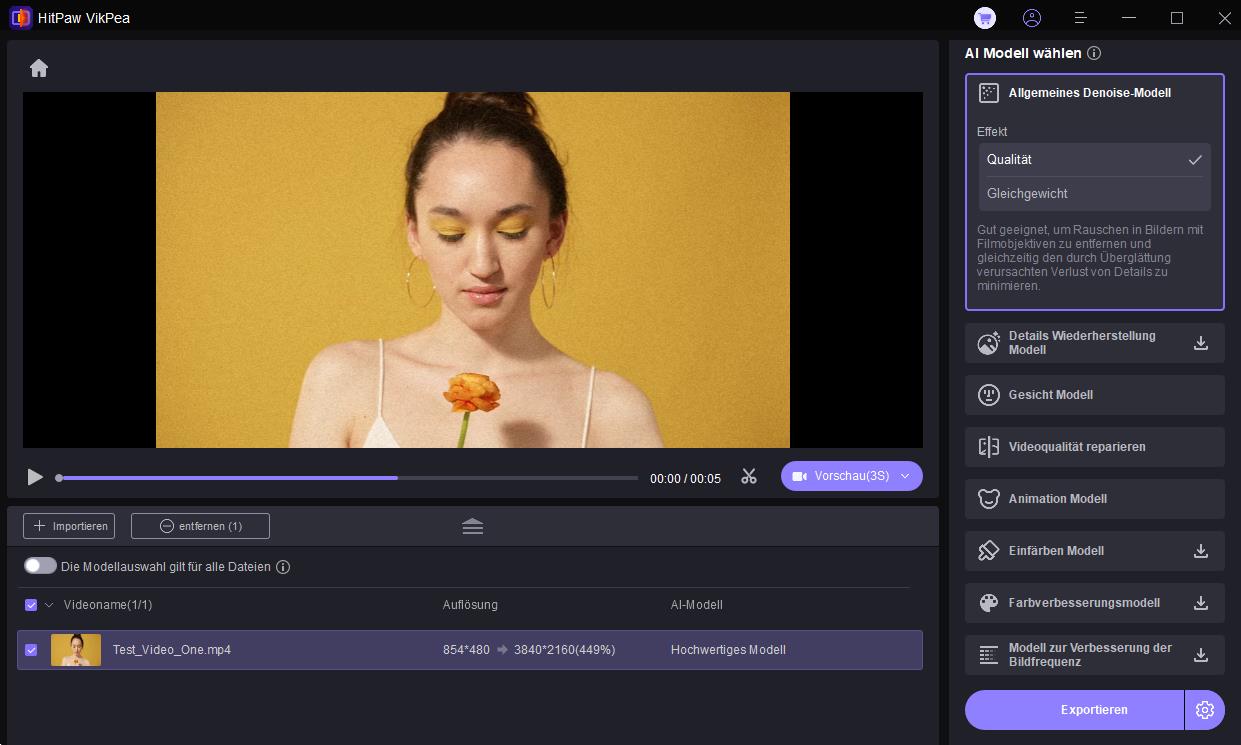

Schritt 2. Modell auswählen: Wählen Sie das KI-Modell aus, das zu Ihrem Filmmaterial passt (z. B. Portrait für Vlogs).

Schritt 3. Vorschau: Klicken Sie auf die Schaltfläche Vorschau, um die Effekte in Echtzeit nebeneinander zu sehen.

Schritt 4. Exportieren mit Beschleunigung: Klicken Sie auf die Schaltfläche Exportieren, um die gesamte Videobearbeitung zu starten. VikPea verwendet standardmäßig die Grafikkarte Ihres Computers. Wenn Sie den Cloud-Export auswählen, wird der Prozess noch schneller beschleunigt.

Teil 4. GPU für KI FAQs

Es hängt von Ihrem Maßstab ab. Für den persönlichen Gebrauch und die Forschung ist die RTX 4090 die beste KI-GPU. Für Unternehmensschulungen ist die NVIDIA H200 der aktuelle Goldstandard.

Nein. Die RTX 4070 hat deutlich mehr CUDA-Kerne und eine höhere Speicherbandbreite, was sie viel effizienter für Deep-Learning-Aufgaben macht.

Mindestens sollten Sie auf eine GPU mit 8GB VRAM für grundlegende Inferenz abzielen. Für das Training werden 24GB dringend empfohlen.

OpenAI nutzt massive Cluster von NVIDIA H100 und A100 GPUs, um Modelle wie GPT-4 und Sora zu trainieren.

NVIDIA ist derzeit überlegen aufgrund des CUDA-Ökosystems, das die am weitesten unterstützte Softwareplattform für die KI-Entwicklung ist.

Fazit

Die Wahl der besten GPU für Deep Learning oder Content Creation erfordert ein Gleichgewicht zwischen VRAM, Rechenleistung und Softwarekompatibilität. Während NVIDIA in der Hardwareführerschaft liegt, stellen Tools wie VikPea sicher, dass Sie jede Leistung aus Ihrer Investition durch optimierte GPU-Beschleunigung herausholen.

Kommentar hinterlassen

Bewertung zu HitPaw-Artikeln erstellen