Beste Open Source KI Video Generatoren 2026: Top-Liste

Künstliche Intelligenz hat die Video-Produktion revolutioniert und den Kreativen Zugang zu Tools gegeben, die mit minimalem Aufwand Animationen, filmische Clips und visuelle Effekte erzeugen können. Unter diesen Tools werden Open Source KI-Video-Generatoren besonders beliebt, da sie kostenlos nutzbar, anpassbar und von großen Entwicklergemeinschaften unterstützt werden. Dieser Artikel untersucht die besten heute verfügbaren Open Source KI-Video-Generatoren, ihre einzigartigen Stärken und wie sie Content Creators empowern können. Schließlich zeigen wir Ihnen auch, wie Sie Ihre KI-generierten Videos mit einem professionellen Video-Enhancement-Tool auf das nächste Level bringen, das Klarheit und Auflösung verbessert.

Teil 1: Was sind Open Source KI-Video-Generatoren

Open Source KI-Video-Generatoren sind Software-Tools, die unter offenen Lizenzen veröffentlicht werden und es jedem ermöglichen, auf den zugrunde liegenden Code zuzugreifen, ihn zu modifizieren und zu verbessern. Sie verwenden maschinelle Lernmodelle, die auf großen Datensätzen trainiert wurden, um Eingaben – sei es Text oder Bilder – in Videoausgaben umzuwandeln.

Die Vorteile sind klar:

- Kosteneffizienz - keine teuren Abonnements.

- Flexibilität - Kreative können Modelle auf spezifische Stile oder Datensätze feinabstimmen.

- Transparenz - Code und Trainingsdaten sind zur Überprüfung offen.

- Gemeinschaftsunterstützung - aktive Foren, GitHub-Repos und Hugging Face Spaces.

Allerdings bringen sie auch Herausforderungen mit sich. Viele benötigen hohe GPU-Leistung, die Setups können technisch sein und die meisten Ausgaben sind auf kurze Clips beschränkt. Daher ist es entscheidend, sie mit Video-Enhancement-Software zu kombinieren, um sie professionell zu nutzen.

Teil 2: Top Open Source KI-Video-Generatoren

1. OpenAI Sora Community Implementations

Obwohl das offizielle Sora-Modell von OpenAI nicht vollständig Open Source ist, haben viele Entwickler community-getriebene Reimplementierungen erstellt, die seine Funktionalität annähern. Diese Tools konzentrieren sich auf physikbewusste Videoerzeugung und erzeugen realistische menschliche und Objektbewegungen. Mit Sora-inspirierten Systemen können Sie detaillierte Eingaben wie "ein Golden Retriever, der am Strand bei Sonnenuntergang apportiert" eingeben und kurze filmische Clips erhalten, die die Physik der realen Welt widerspiegeln.

- Physikbewusste Bewegung: Bessere Handhabung von Objektinteraktionen und natürlicher Bewegung.

- Multi-Framework-Support: Implementierungen existieren für PyTorch und JAX-Backends.

- Leichtgewichtige Bereitstellung: Entwickelt, damit kleinere Teams Experimente auf Mid-Range-Hardware durchführen können.

- Erweiterbare Pipelines: Plugin-Architektur für Bewegungsprioritäten, Stiladapter und benutzerdefinierte Sampler.

Am besten für: Forscher und fortgeschrittene Kreative, die eine hochmoderne Text-zu-Video-Leistung wünschen.

2. SkyReels

SkyReels V2 ist ein leichtgewichtiges, Open Source Modell, das für schnelle und kreative Kurzform-Inhalte entwickelt wurde. Es ist weit verbreitet auf Hugging Face verfügbar, mit einer florierenden Entwicklergemeinschaft, die regelmäßig vortrainierte Checkpoints aktualisiert. SkyReels konzentriert sich auf Geschwindigkeit und Einfachheit und erzeugt stilisierte Video-Sequenzen in nur wenigen Sekunden. Seine verspielte Ästhetik macht es bei Meme-Erstellern, Indie-Filmemachern und Social Media-Inhaltsdesignern beliebt.

- Transformer-Stil Eingabe-Encoding: Bessere Auffassung komplexer Eingaben.

- Verbesserte Frame-Konsistenz (V2): Reduziert Flimmern und Charakterdrift über Frames hinweg.

- Niedriger Ressourcenverbrauch: Entwickelt für Desktop-Nutzung ohne Unternehmens-GPUs.

- Stilsteuerungen und Eingabeerweiterungen: Ermöglicht fein abgestimmte Kontrolle über Kamerabewegung, Farbpalette und Stimmung.

Am besten für: TikTok- oder Instagram-Creators, die mit schnell produzierten KI-Video-Inhalten experimentieren möchten.

3. Stable Video Diffusion

Stability AI hat Stable Video Diffusion entwickelt, das auf dem Erfolg von Stable Diffusion für Bilder aufbaut. Es kann sowohl Texteingaben als auch Standbilder in bewegte Videosequenzen umwandeln. Mit Funktionen wie sanfter Frame-Interpolation und Stilkontrolle können Kreative Animationen erzeugen, die je nach Einstellung handgezeichnet oder filmisch aussehen. Da es vollständig Open Source ist, können Entwickler es weiter auf ihren eigenen Datensätzen trainieren, um Stile wie Anime, Film Noir oder 3D-Renderings anzupassen.

- Bild→Video-Pipeline: Animieren von Standbildern oder Bewegung aus Eingabesequenzen erstellen.

- Große Gemeinschaft & Tools: Viele Community-Gabelungen, Sampler und Stil-Checkpoints verfügbar.

- Stil und Kontrolle: Stärke in der konsistenten Anwendung visueller Stile (malerisch, Anime, fotorealistisch) über Frames hinweg.

- Temporale Konditionierung & Flusssteuerung: Verwendet Bewegungsführung oder optischen Fluss, um die Rahmenkohärenz zu erhalten.

Am besten für: Animatoren, experimentelle Kreative und Entwickler, die ein vielseitiges und hackbares Modell wünschen.

4. ModelScope Text-to-Video

Entwickelt von Alibabas DAMO Academy, ist ModelScope T2V einer der frühesten und zugänglichsten Text-zu-Video-Generatoren. Es wird auf Hugging Face gehostet, was es einfach macht, im Browser ohne lokale Installation auszuprobieren. Obwohl die Videoqualität auf kurze Clips von 2-5 Sekunden beschränkt ist, bietet es eine zuverlässige Eingabesicherheit und ist ein guter Einstiegspunkt für Anfänger. Viele Kreative verwenden es auch als Basisschicht und verbessern und erweitern die Clips dann mit Bearbeitungssoftware.

- Benutzerfreundliche Pipeline: Fertige Skripte und gehostete Demos für sofortige Tests.

- Stable Diffusion-Stil Diffusoren: Verwendet Diffusionsarchitekturen, die für die Genauigkeit der Texteingabe optimiert sind.

- Hugging Face & ModelScope-Integration: Einfach, Gewichte zu greifen, im Browser auszuprobieren oder Notebooks auszuführen.

- Feinabstimmung & Transfer: Unterstützt gängige Feinabstimmungstechniken wie LoRA.

Am besten für: Pädagogen, Hobbyisten und Erstnutzer, die mit KI-Video experimentieren.

5. VideoCrafter

VideoCrafter ist ein multimodales Open Source Framework, das sich darauf konzentriert, kurze filmische Clips aus Text, Standbildern oder durch Fortsetzung bestehender Videos zu erstellen. Es betont die Erhaltung von Bilddetails bei gleichzeitiger Hinzufügung von natürlicher Bewegung – eine gute Wahl, wenn Sie Illustrationen animieren oder narrative Ausschnitte mit kohärenter Szenenstruktur produzieren möchten.

- Multimodale Erzeugung: Text→Video, Bild→Video (ein einzelnes Bild animieren) und Video-Fortsetzung (einen Eingabeclip verlängern).

- Diffusionsbasierte Kern: Verwendet Diffusionstechniken, um Bewegung hinzuzufügen, während die Komposition und Textur der Quelle erhalten bleibt.

- Cinematische Ausgabe: Einstellbar, um geschichtengetriebene Clips mit guter räumlicher und temporaler Kohärenz zu produzieren.

- Anpassbare Parameter: Auflösung, Bildrate, Anzahl der Diffusionsschritte und Leitmaßstab für Eingabegenauigkeit.

- Plug-in-freundlich: Häufig mit FFmpeg zur Kodierung integriert, plus optionale Nachbearbeitungs-Hooks für Farbkorrektur.

Beste Anwendungsfälle: Demonstration von Storyboards, bei denen die Handlungs-Kontinuität wichtig ist, Produktion von Konzept-Szenen für Kurzfilme, Forschung zur Sprache→visuellen Sequenz-Ausrichtung.

6. CogVideoX

CogVideoX ist ein Mitglied der transformergetriebenen Text-zu-Video-Familie, die darauf ausgelegt ist, zu skalieren: Betonung längerer kontextueller Eingaben, narrative Kohärenz über mehrere Szenen und bessere Handhabung komplexer Aktionen und Interaktionen.

- Transformer-Rückgrat: Verwendet autoregressive oder bedingte Transformer-Schichten, um längere Sequenzen und Mehrturnaktionen zu modellieren.

- Text-zu-Video-Stärke: Besser im Folgen von ausführlichen Beschreibungen mit mehreren Akteuren und Aktionen.

- Feinabstimmungsbereit: Entwickelt, um domänenspezifische Feinabstimmungen (LoRA-Stil oder vollständige Checkpoint-Neu-Training) zu akzeptieren.

- Temporale Konditionierungswerkzeuge: Szenensegmentierung und Aktionstoken zur Aufrechterhaltung der Kontinuität.

Am besten für: Demonstration von Storyboards, bei denen die Handlungs-Kontinuität wichtig ist, Produktion von Konzept-Szenen für Kurzfilme, Forschung zur Sprache - visuellen Sequenz-Ausrichtung.

Teil 3: KI-generierte Videos mit HitPaw VikPea verbessern

Obwohl Open Source KI-Video-Generatoren beeindruckende Clips erstellen können, leiden viele Ausgaben immer noch unter niedriger Auflösung, körnigen Texturen oder inkonsistenter Bildqualität. Um ihr volles Potenzial zu entfalten, benötigen Sie ein leistungsstarkes Enhancement-Tool. Hier wird HitPaw VikPea zum perfekten Partner für Ihre KI-generierten Videos. Es ist nicht nur für Filme und persönliche Aufnahmen konzipiert, sondern auch zur Optimierung von KI-generierten Videoinhalten. Egal, ob Ihr Video verschwommen aussieht, Details fehlen oder Rauschen vorhanden ist, VikPea verbessert es mit einem einzigen Klick.

- 8K-Upscaling:KI-generierte Clips in filmische Qualität umwandeln.

- Mehrere KI-Modelle:Modelle auswählen, die auf Rauschunterdrückung, Gesichtsdetailwiederherstellung oder Animationsverbesserung zugeschnitten sind.

- Batch-Verarbeitung:Zeit sparen, indem mehrere KI-Video-Clips gleichzeitig verbessert werden.

- Plattformübergreifend:Verfügbar sowohl für Windows als auch für macOS.

- Anfängerfreundliche Benutzeroberfläche:Einfach für Kreative ohne technischen Hintergrund.

Wie man HitPaw VikPea zur Verbesserung von KI-Videos verwendet

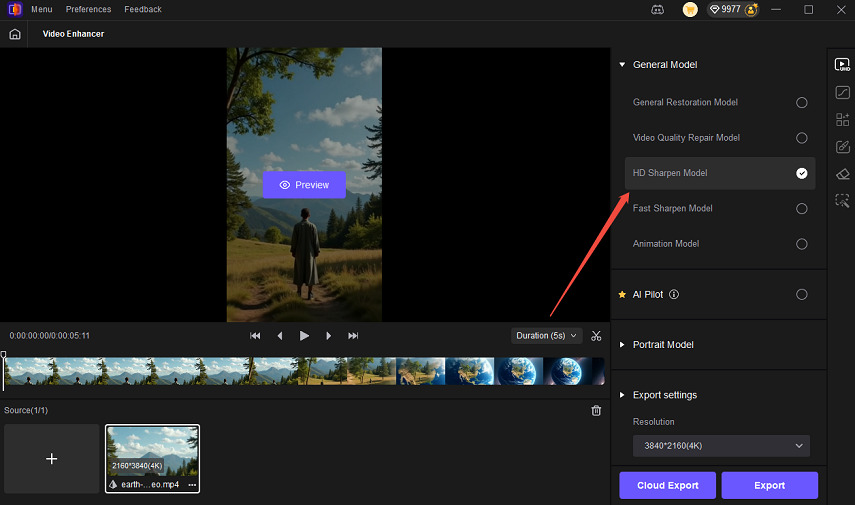

Schritt 1: Laden Sie HitPaw VikPea auf Ihren Computer herunter und installieren Sie es. Importieren Sie KI-generierte Videos aus dem Open-Source-Video-Generator.

Schritt 2: Wählen Sie das Verbesserung Modell je nach Ihrem Video-Typ, hier können Sie das Schärfemodell für KI-Videos auswählen.

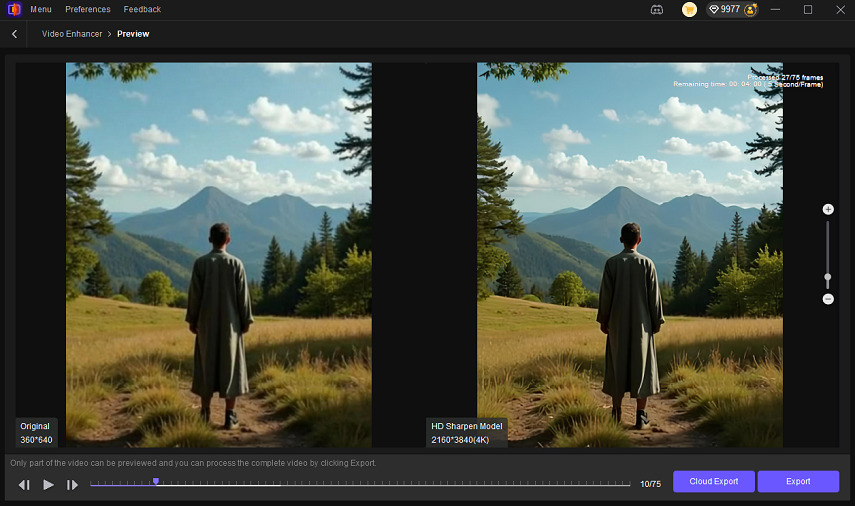

Schritt 3: Vorschau der Ergebnisse vor dem Export. Exportieren in 4K oder 8K für professionelle Qualität.

FAQs zu Open Source KI-Video-Generatoren

Ja, die meisten Open Source Modelle sind kostenlos, einige benötigen jedoch leistungsstarke GPUs für die besten Ergebnisse.

ModelScope ist oft der einfachste Einstieg dank seiner einsatzbereiten Pipelines.

Ja, aber laden Sie immer von vertrauenswürdigen Quellen wie Hugging Face oder GitHub herunter, um bösartige Versionen zu vermeiden.

Fazit

Der Aufstieg der Open Source KI-Video-Generatoren demokratisiert die Videoerstellung und ermöglicht es jedem, mit fortschrittlichen KI-Tools zu experimentieren, ohne teure Abonnements. Plattformen wie Stable Video Diffusion, SkyReels V2 und ModelScope drücken die Grenzen dessen, was in kreativen Erzählungen möglich ist. Da viele Ausgaben jedoch immer noch in Auflösung und Klarheit begrenzt sind, sorgt die Kombination dieser Tools mit HitPaw VikPea dafür, dass Ihre Videos professionell und auffällig sind.

Wenn Sie die Zukunft der KI-Videoerstellung erkunden möchten, beginnen Sie mit Open Source-Modellen – und lassen Sie HitPaw VikPea Ihre Ergebnisse auf das nächste Level heben.

HitPaw FotorPea

HitPaw FotorPea HitPaw VoicePea

HitPaw VoicePea  HitPaw Univd

HitPaw Univd

Teilen zu:

Wählen Sie die Produktbewertung:

Joshua Hill

Chefredakteur

Ich bin seit über fünf Jahren als Freiberufler tätig. Es ist immer beeindruckend Wenn ich Neues entdecke Dinge und die neuesten Erkenntnisse, das beeindruckt mich immer wieder. Ich denke, das Leben ist grenzenlos.

Alle Artikel anzeigenEinen Kommentar hinterlassen

Eine Bewertung für HitPaw Artikel abgeben